Функция активации (сигмоида):

Сигмоидальная функция \( \sigma(x) \) преобразует любое вещественное число в значение от 0 до 1. Она часто используется в выходных слоях для задач классификации или в скрытых слоях.

\[ \sigma(x) = \frac{1}{1 + e^{-x}} \]Производная функции активации (для обратного распространения ошибки, если потребуется):

\[ \sigma'(x) = \sigma(x) \cdot (1 - \sigma(x)) \]Нейрон:

Нейрон принимает на вход несколько значений, умножает их на соответствующие веса, суммирует результаты, добавляет смещение (порог) и пропускает через функцию активации.

\[ \text{output} = \sigma \left( \sum_{i=1}^{n} (x_i \cdot w_i) + b \right) \]где:

- \( x_i \) — входное значение

- \( w_i \) — вес, соответствующий входному значению \( x_i \)

- \( b \) — смещение (порог)

- \( \sigma \) — функция активации

Теперь реализуем классы нейросетей для каждого из заданных случаев.

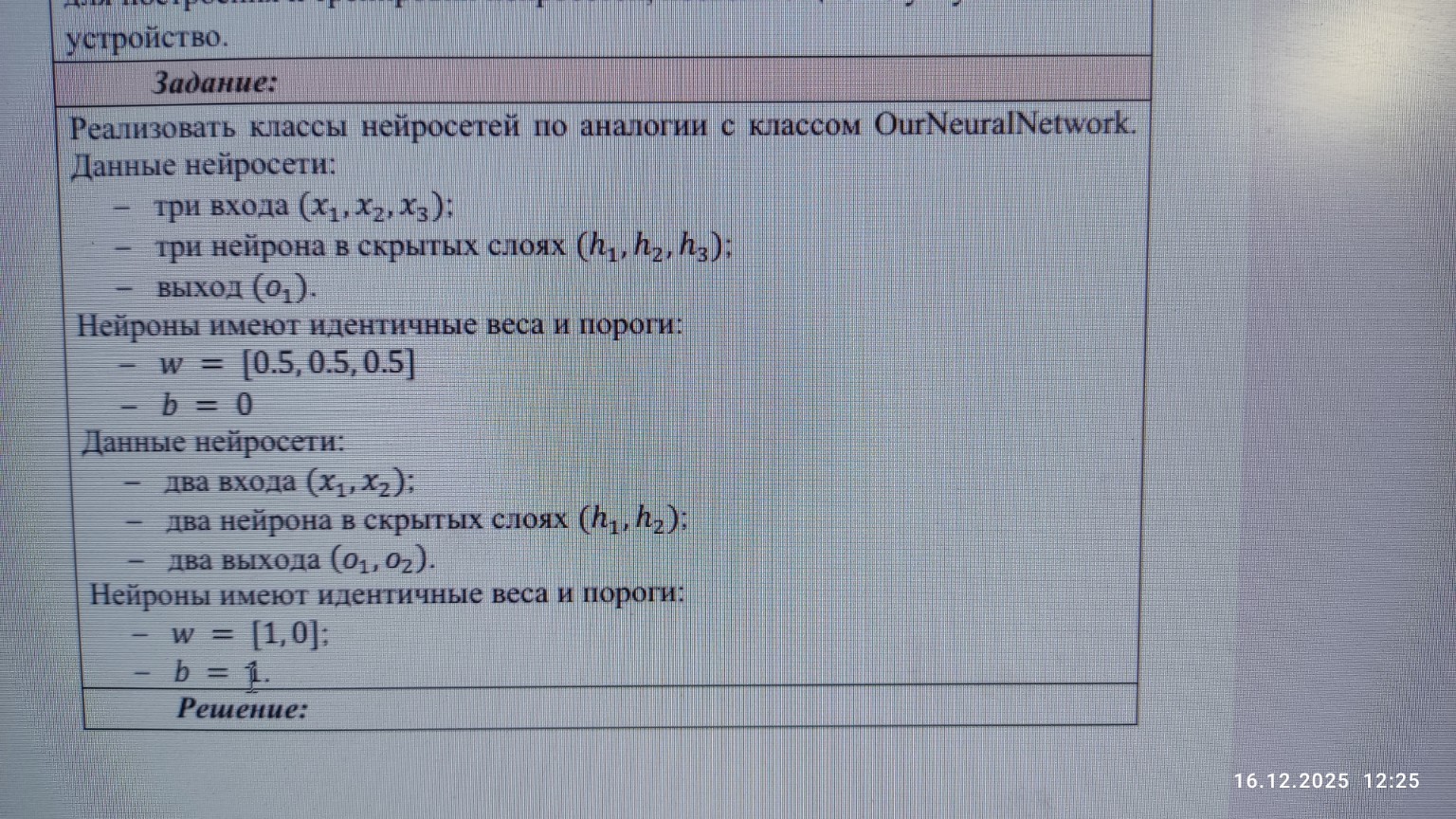

1. Первая нейросеть:

- Три входа (\( x_1, x_2, x_3 \))

- Три нейрона в скрытых слоях (\( h_1, h_2, h_3 \))

- Один выход (\( o_1 \))

- Идентичные веса и пороги: \( w = [0.5, 0.5, 0.5] \), \( b = 0 \)

Эта нейросеть имеет один скрытый слой с тремя нейронами и один выходной нейрон. Каждый нейрон в скрытом слое будет принимать все три входа. Выходной нейрон будет принимать выходы скрытых нейронов.

Расчеты для первой нейросети:

Скрытый слой:

Поскольку веса и пороги идентичны для всех нейронов, каждый нейрон в скрытом слое будет иметь одинаковый входной сигнал до активации.

Для нейрона \( h_1 \):

\[ \text{sum}_{h_1} = (x_1 \cdot w_1) + (x_2 \cdot w_2) + (x_3 \cdot w_3) + b \] \[ \text{sum}_{h_1} = (x_1 \cdot 0.5) + (x_2 \cdot 0.5) + (x_3 \cdot 0.5) + 0 \] \[ \text{sum}_{h_1} = 0.5 \cdot (x_1 + x_2 + x_3) \] \[ h_1 = \sigma(\text{sum}_{h_1}) \]Аналогично для \( h_2 \) и \( h_3 \):

\[ \text{sum}_{h_2} = 0.5 \cdot (x_1 + x_2 + x_3) \] \[ h_2 = \sigma(\text{sum}_{h_2}) \] \[ \text{sum}_{h_3} = 0.5 \cdot (x_1 + x_2 + x_3) \] \[ h_3 = \sigma(\text{sum}_{h_3}) \]Выходной слой:

Выходной нейрон \( o_1 \) принимает на вход выходы скрытых нейронов \( h_1, h_2, h_3 \). Веса для этого слоя также будут \( [0.5, 0.5, 0.5] \) и порог \( 0 \), если не указано иное. Предполагаем, что "Нейроны имеют идентичные веса и пороги" относится ко всем нейронам в сети.

\[ \text{sum}_{o_1} = (h_1 \cdot w_1) + (h_2 \cdot w_2) + (h_3 \cdot w_3) + b \] \[ \text{sum}_{o_1} = (h_1 \cdot 0.5) + (h_2 \cdot 0.5) + (h_3 \cdot 0.5) + 0 \] \[ \text{sum}_{o_1} = 0.5 \cdot (h_1 + h_2 + h_3) \] \[ o_1 = \sigma(\text{sum}_{o_1}) \]2. Вторая нейросеть:

- Два входа (\( x_1, x_2 \))

- Два нейрона в скрытых слоях (\( h_1, h_2 \))

- Два выхода (\( o_1, o_2 \))

- Идентичные веса и пороги: \( w = [1, 0] \), \( b = 1 \)

Эта нейросеть имеет один скрытый слой с двумя нейронами и один выходной слой с двумя нейронами.

Расчеты для второй нейросети:

Скрытый слой:

Для нейрона \( h_1 \):

\[ \text{sum}_{h_1} = (x_1 \cdot w_1) + (x_2 \cdot w_2) + b \] \[ \text{sum}_{h_1} = (x_1 \cdot 1) + (x_2 \cdot 0) + 1 \] \[ \text{sum}_{h_1} = x_1 + 1 \] \[ h_1 = \sigma(\text{sum}_{h_1}) \]Для нейрона \( h_2 \):

\[ \text{sum}_{h_2} = (x_1 \cdot w_1) + (x_2 \cdot w_2) + b \] \[ \text{sum}_{h_2} = (x_1 \cdot 1) + (x_2 \cdot 0) + 1 \] \[ \text{sum}_{h_2} = x_1 + 1 \] \[ h_2 = \sigma(\text{sum}_{h_2}) \]Выходной слой:

Выходные нейроны \( o_1 \) и \( o_2 \) принимают на вход выходы скрытых нейронов \( h_1, h_2 \). Веса для этого слоя также будут \( [1, 0] \) и порог \( 1 \).

Для нейрона \( o_1 \):

\[ \text{sum}_{o_1} = (h_1 \cdot w_1) + (h_2 \cdot w_2) + b \] \[ \text{sum}_{o_1} = (h_1 \cdot 1) + (h_2 \cdot 0) + 1 \] \[ \text{sum}_{o_1} = h_1 + 1 \] \[ o_1 = \sigma(\text{sum}_{o_1}) \]Для нейрона \( o_2 \):

\[ \text{sum}_{o_2} = (h_1 \cdot w_1) + (h_2 \cdot w_2) + b \] \[ \text{sum}_{o_2} = (h_1 \cdot 1) + (h_2 \cdot 0) + 1 \] \[ \text{sum}_{o_2} = h_1 + 1 \] \[ o_2 = \sigma(\text{sum}_{o_2}) \]Вывод:

В обоих случаях, из-за идентичных весов и порогов для всех нейронов в каждом слое, а также одинаковых входных данных для нейронов одного слоя, выходы нейронов в одном слое будут одинаковыми. Это упрощает расчеты, но в реальных нейросетях веса обычно инициализируются случайным образом и обучаются.